谷歌I/O 2025:Gemini驱动的AI超级生态,安全与透明同行

💁♂️引言

上周,我连续追看了微软、谷歌和Anthropic三大AI巨头的年度发布会。现场展示的AI新技术令人目不暇接,一时激情澎湃。但当我关掉直播屏幕,静下心来思考,内心却生出几分冷静与自省——AI的”大时代”已然到来,我们每个人又该以怎样的姿态拥抱这场浪潮?

接下来,我想用7张图,把”AI周”最震撼的技术时刻和我的一点冷静思考分享给你: 👉第2张图:Google I/O 2025

🤖 AI PowerPlays #2: Google & Gemini Everywhere

🌟 谷歌AI生态八大特征

- 🌐 以Gemini为核心引擎

- 🏆 以推理能力升级为动力

- 🛡️ 以安全合规为底线

- 🕸️ 以全场景融合为优势

- 📲 以跨端多模态为亮点

- 🔄 以开放协作为路径(MCP标准兼容)

- 🛠️ 以AI开发者友好为基础

- 🚀 以创新商业模式为探索

🚀 结论先行:Gemini驱动的AI超级生态,安全与透明同行

谷歌在 I/O 2025 上以 Gemini 2.5 Pro 为代表的AI模型体系,强势展示了”全域AI布局”的战略决心。从底层模型升级、AI搜索变革,到多模态创意生成和智能助手渗透每一款应用,谷歌试图用 Gemini 体系搭建起一个无处不在、场景无死角的AI超级生态。但在”AI无所不在”的背后,安全与透明也成为衡量AI创新可持续的底线。

🌐 Gemini 2.5 Pro:推理力与全场景的AI引擎

本届 I/O,谷歌将 Gemini 2.5 Pro 推到舞台中央——它不仅在对话、代码生成、多模态任务上全面赶超前代,还引入了”深度思考””思维链”等前所未有的推理机制。特别是 100万Token 超长上下文窗口、链式推理透明展示,以及高级安全防护,为开发者和企业用户带来了更高的可靠性和可解释性。

在安全层面,谷歌强调通过内容过滤、推理路径公开、API级安全设置等方式,最大程度降低大模型误判与数据泄露风险。同时Gemini已兼容MCP协议,这种开放姿态让AI生态有望实现跨平台的数据安全协作。

🕸️ 全域AI赋能:搜索、办公、创意到”无处不在”

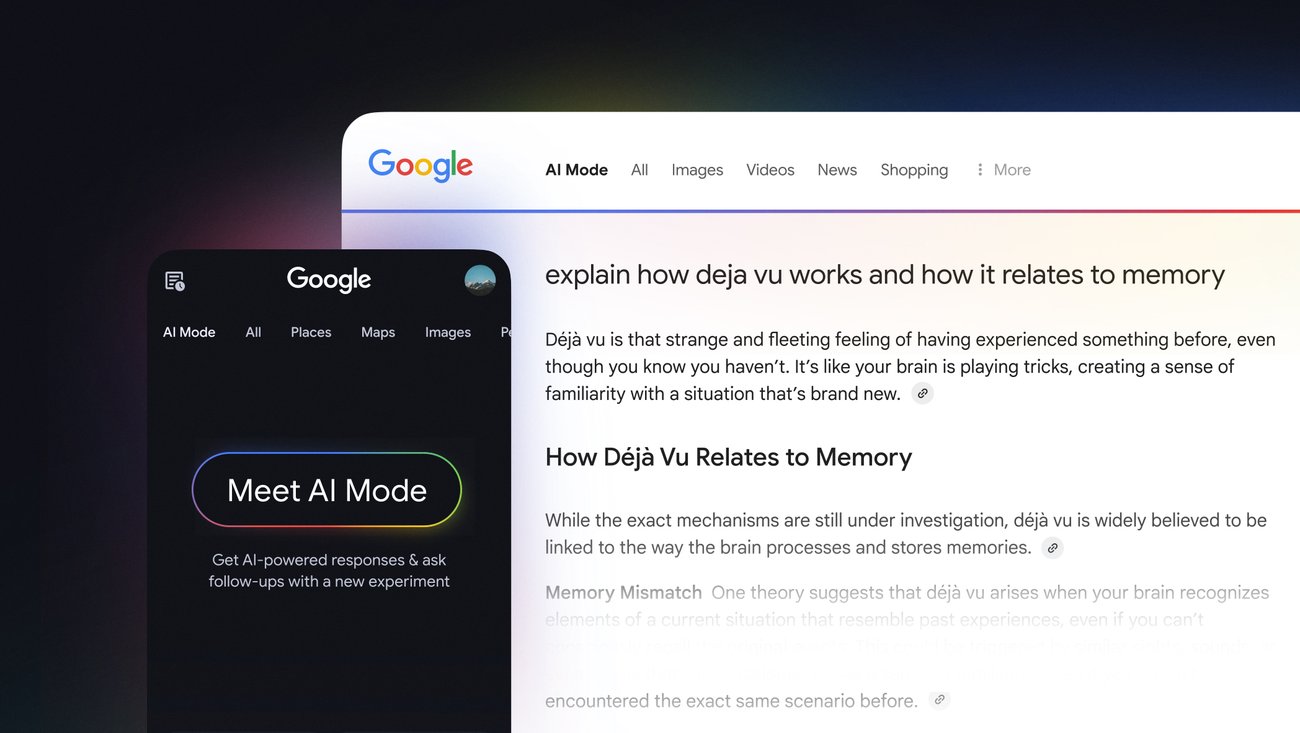

Gemini不仅升级了模型本身,更彻底”渗透”谷歌核心产品。AI搜索模式(AI Mode)将多模态推理和实时感知能力引入主流搜索场景,重塑了用户”信息获取”的体验——让”答案、溯源、参考”一步到位,极大提升了信息透明度和安全感。在Gmail、Docs、Sheets、Chrome等平台的深度集成,也让每一位用户都能以安全、可控的方式调用AI助手,提升生产力的同时保障隐私。

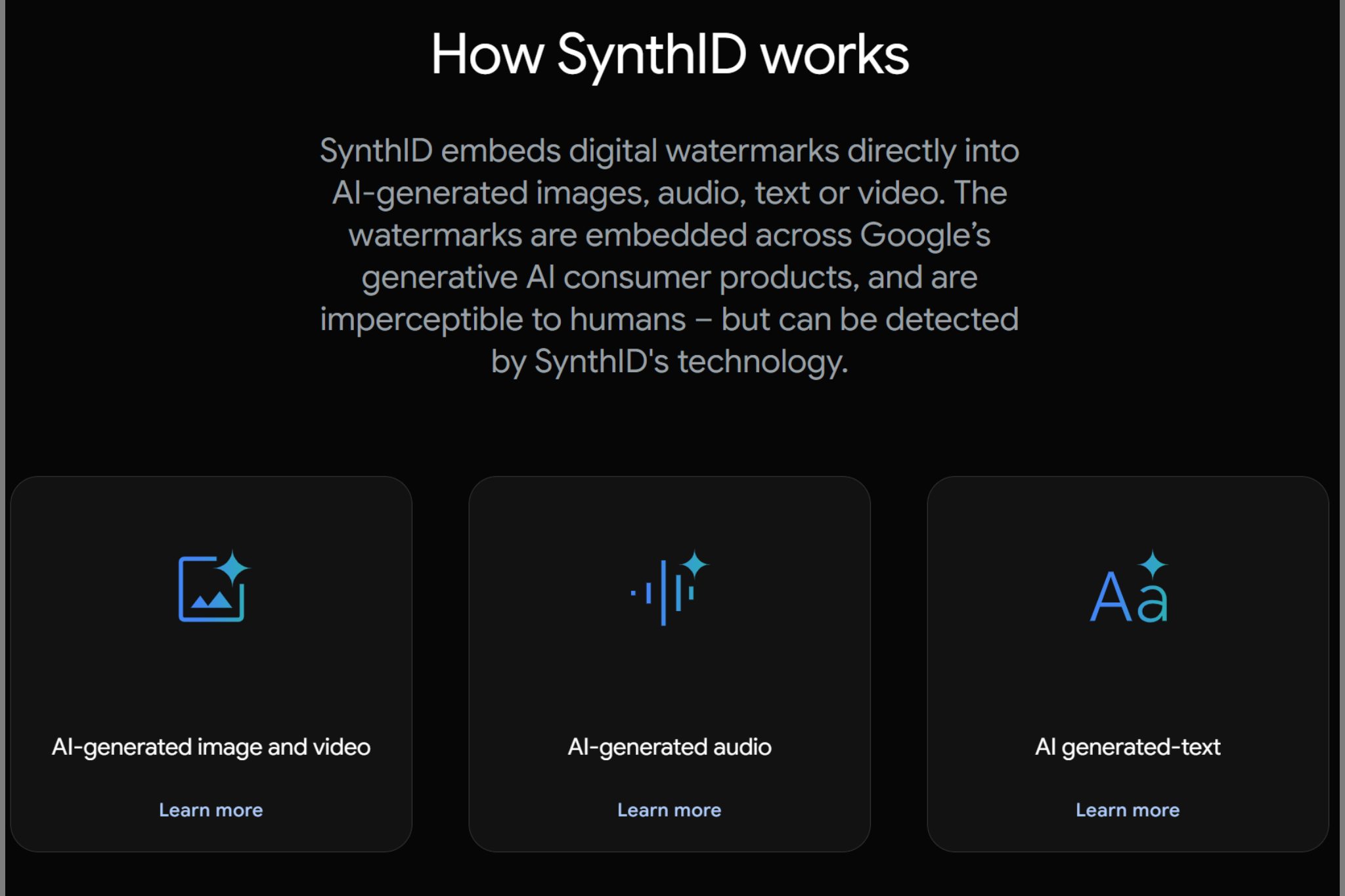

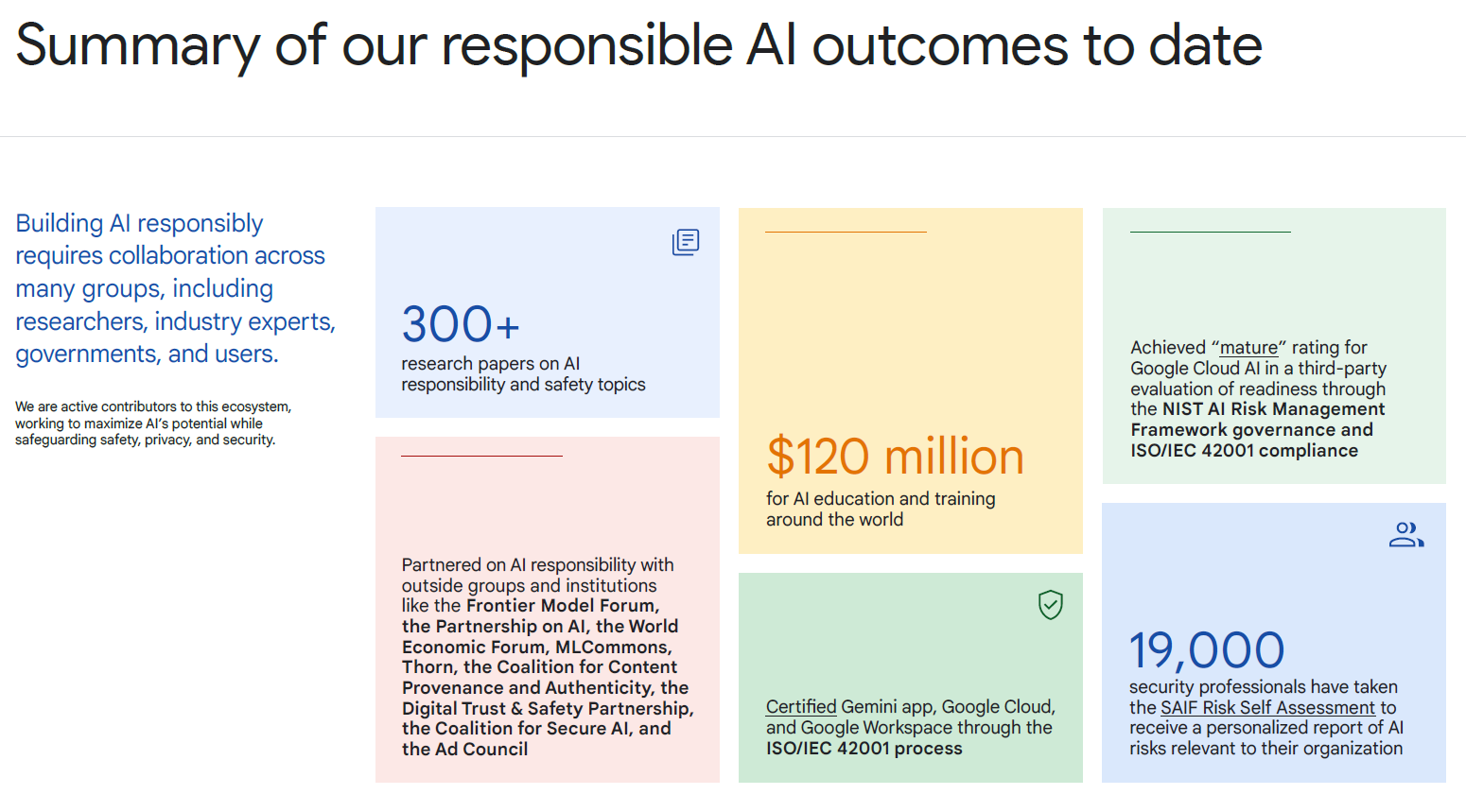

多模态生成能力(Veo 3、Imagen 4、Lyria 2等)的突破为内容创作者带来创新空间的同时,也带来了内容溯源和安全检测的新挑战。对此,谷歌不仅推出SynthID等AI生成内容检测平台,还通过开放治理双轨并行的策略,系统性地回应社会对AI内容安全的关切,特别是在教育等关键领域进行专项模型评测,确保技术应用的安全可靠。

🦾 安全治理与AI时代的信任护栏

在这场重塑AI竞赛格局的发布中,谷歌展现出双重战略:一方面通过Gemini 2.5 Pro等创新技术重新定义行业标准,倒逼竞争对手加速迭代;另一方面,大规模AI融入核心产品的激进策略也意味着前所未有的风险——任何安全漏洞或内容失误都可能造成系统性影响。正因如此,谷歌将”安全、合规、负责“作为本次发布会的核心主题,不遗余力构建全链路防护体系。下面重点对其Responsible AI实践进行简析。

📦 谷歌 Responsible AI 实践简析

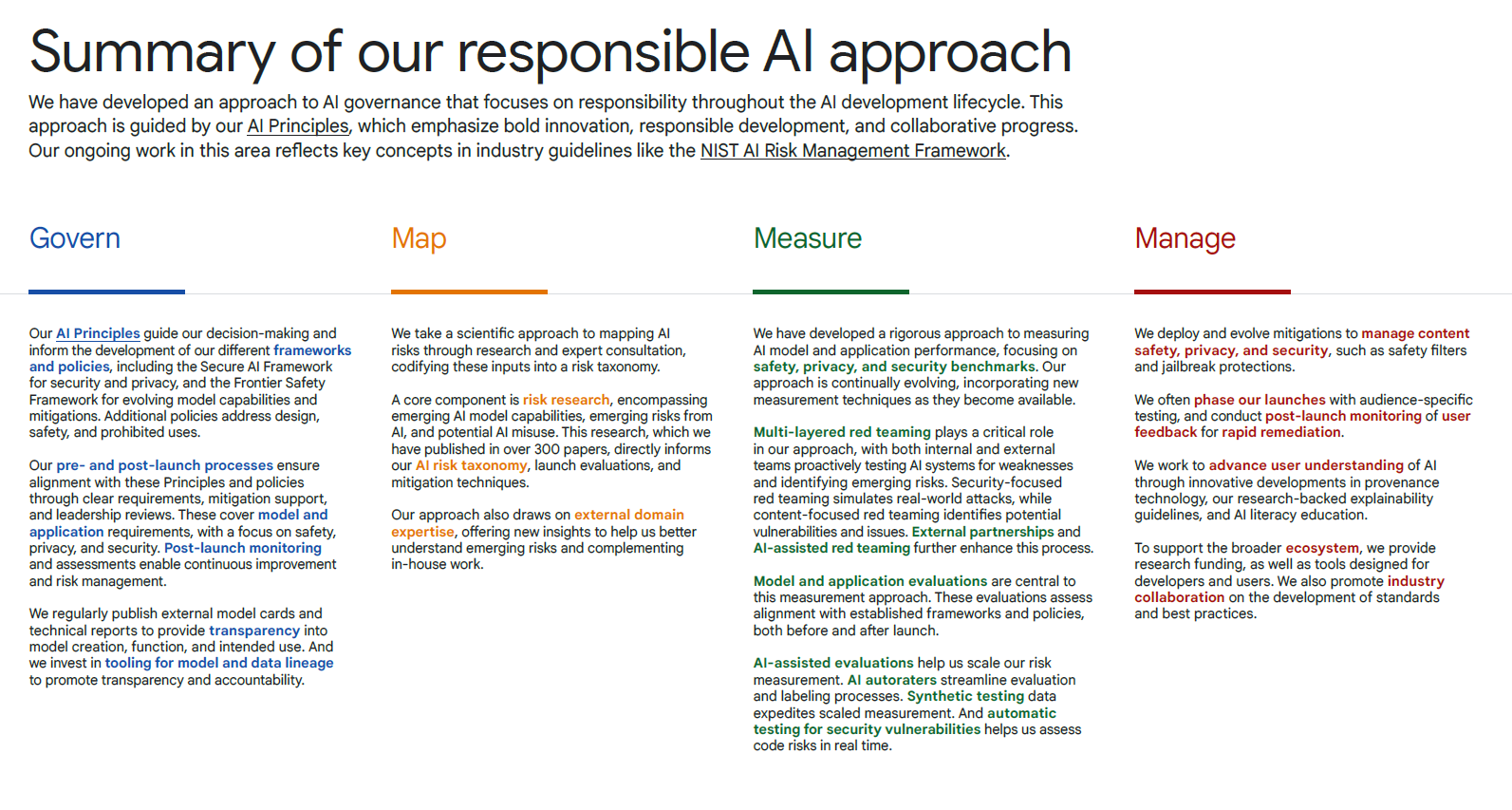

谷歌的 Responsible AI 实践是一套”全栈、全周期、全透明”的安全与合规体系。其核心精髓包括:

- 🧭 原则驱动(AI Principles):坚持”大胆创新,责任优先”,将合规、安全与治理嵌入AI开发每一步。

- 🗺️ 风险地图与多层防护(Risk Mapping & Multi-layer Protection):利用 NIST 框架和自主风险模型,针对 AI 各阶段可能的安全、隐私、透明等问题进行提前识别、全流程监控和动态防护,并通过多层 red teaming 进行实战验证。

- 🔍 可解释与可追溯(Explainability & Traceability):通过外部 Model Cards、透明报告和水印等技术,确保每一次 AI 推理都”有迹可循”,让结果”看得懂、查得到、管得住”。

- 🚦 分阶段发布与快速响应(Phased Rollout & Rapid Response):重大 AI 功能分阶段、分群体上线,不断收集用户反馈、监控风险,实现”边运行边优化”,形成”活的安全治理”。

- 🌱 生态共建(Ecosystem Co-building):开源安全工具、共享行业标准,与国际组织、行业伙伴共同提升AI安全水准,让安全不只是谷歌的责任,也是整个社会的共识和基线。

🎯 形象精髓比喻

谷歌的Responsible AI,就像AI世界里的交通规则与安全气囊——它不仅为AI创新划定红绿灯、修好护栏,更在每一次模型加速前都准备好刹车与气囊,让所有人都能既安心又高效地驰骋AI高速公路。

🛡️ 网络安全从业者的启示与参考

对我们网络安全人员而言,谷歌 Responsible AI 实践最大的借鉴是:安全不是AI研发的”最后一关”,而要像地基一样深深打入每一层产品设计和治理流程之中。

在日常工作中,我们可以:

- 🕵️♂️ 主动参与:在AI项目初期就介入风险评估和治理设计,确保安全前置

- 🚦 推动建立:帮助企业构建分阶段发布机制,配合持续监控和应急响应体系

- 🔍 倡导透明:推动数据和模型的可解释性建设,确保每个AI决策都可追溯验证

- 🤝 共建生态:参与行业安全标准制定,与合作伙伴共同打造AI安全防线

💡 金句点睛:

“AI的未来,既需要创新的翅膀,更需要安全的地基。让安全成为每一次AI创新的底色,才是行业共同奔赴远方的起点。”

✨ 个人感悟:安全为AI创新的底色

站在网络安全专业的角度,谷歌I/O 2025带来的最大启发是:“AI越无所不在,安全与合规越要提前布局。” 谷歌通过开放标准兼容、多重安全策略和内容溯源机制,把安全治理从单点工具提升为平台级基础设施。对于企业和开发者来说,AI的强大能力必须以可控、可审计、可溯源的安全体系为基础,只有这样,才能真正放心将AI引入业务、创造价值。

“AI生态的竞争,终将回归信任与安全的本质。谷歌的实践为行业树立标杆:让安全成为AI创新的地基,让信任成为技术突破的翅膀。”